En febrero de 2023, una investigación de un medio de verificación venezolano (Cazadores de Fake News) sobre el uso de falsos "periodistas" —en rigor, animaciones digitales realistas de humanos— para difundir narrativas favorables al oficialismo alcanzó resonancia en medios internacionales como El País y The Washington Post. También la reflejamos en EsPaja.com. Una de las consecuencias que trajo fue la supresión de canales que difundían estos videos en la plataforma YouTube.

¿Qué era lo llamativo de estos videos? Incluso aunque no podían considerarse ejemplos de animaciones digitales extremadamente costosas o avanzadas —a diferencia de un inquetante deepfake del actor Morgan Freeman divulgado en 2021—, muchas personas los vieron, por ejemplo, en programas de VTV, y probablemente no detectaron de inmediato que se trataba de "avatares".

De hecho, la investigación principal de Cazadores de Fake News no se basaba en la animación de avatares en sí, sino en su contexto. Por ejemplo, a través de una búsqueda inversa en Internet, se descubrió que el "periodista" de uno de los falsos reportajes periodísticos se repetía con un aspecto casi idéntico y fondos diferentes en múltiples "advocaciones":

Del "valle inquietante" al "pico indistinguible"

La historia del deepfake (animaciones digitales o manipulaciones extremadamente realistas con potencial de uso para la desinformación) está muy emparentada con la del cine de Hollywood.

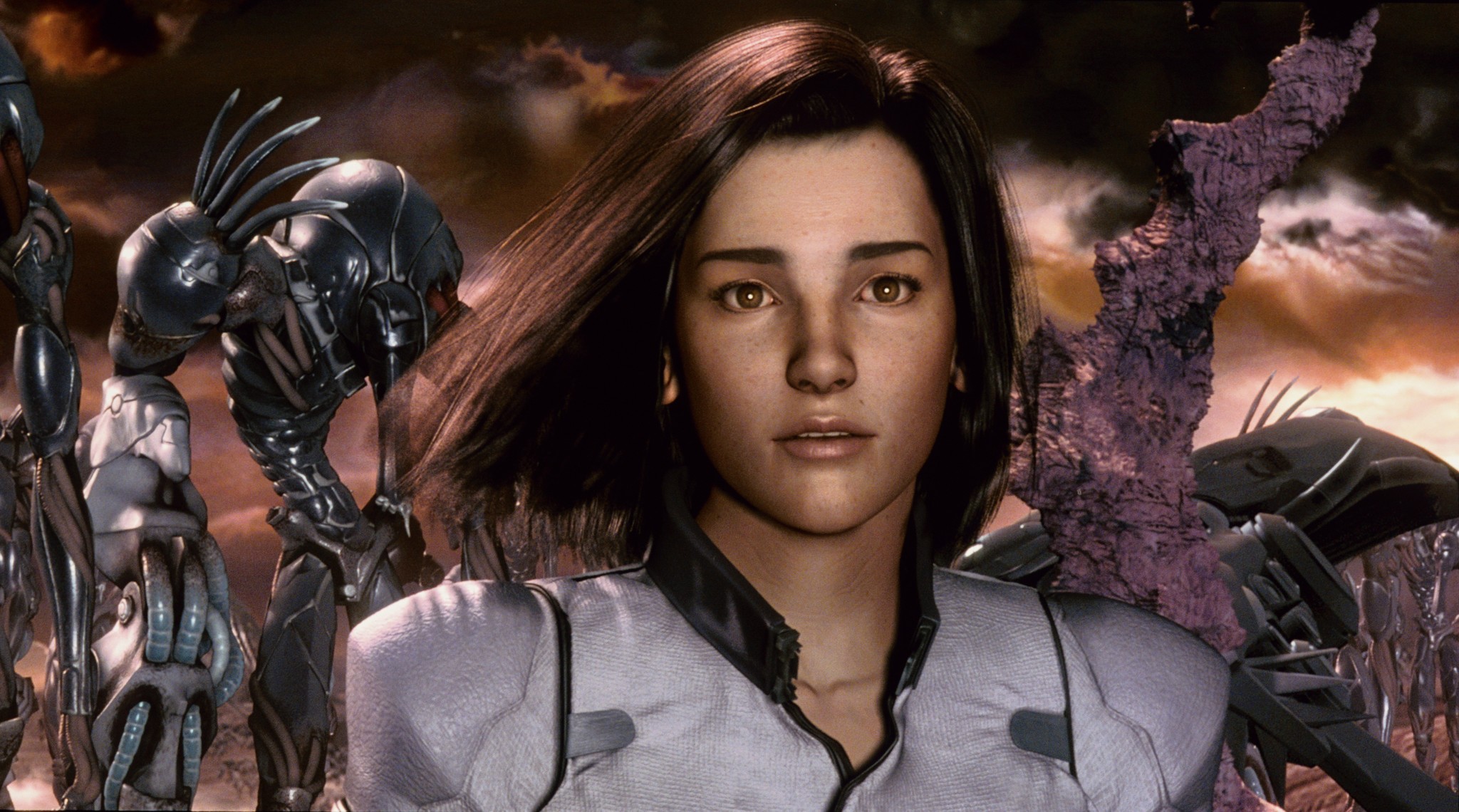

En 2001, una película basada en un videojuego y protagonizada por una "heroína" creada con animación digital, Final Fantasy: The Spirits Within, se convirtió en un fracaso estrepitoso, a pesar de que entonces representaba la cúspide de la tecnología.

Una obra de entretenimiento puede fracasar por múltiples razones, pero parte del rechazo del público se atribuyó a la teoría llamada "Valle Inquietante" (Uncanny Valley), expresión que se deriva de un gráfico de curvas.

Fotograma de Aki, la heroína digital de 2001 que aún no era suficientemente realista

Según esta teoría, una figura antropomórfica, pero que sabemos que es ficticia (por ejemplo, la Blancanieves dibujada a mano en la película de Walt Disney de 1937), psicológicamente genera más simpatía que una animación, digital, realista y de aspecto tridimensional, pero en la que todavía distinguimos a simple vista gestos o detalles poco humanos.

En otras palabras: un "avatar" imperfecto —desarrollado con una tecnología todavía incipiente— puede generar un gran rechazo, incomodidad e inquietud entre los espectadores. Para ahondar en esta teoría sobre la percepción psicológica de la animación 3D, se puede revisar este trabajo de Víctor Daniel Maldonado, profesor de la Universidad Central del Ecuador.

Para 2023, prácticamente podemos afirmar que el "Valle Inquietante" ha sido desplazado por un "pico" casi indistinguible. Es decir, estamos llegando a un punto de la tecnología en el que cada vez será más difícil distinguir a simple vista que no estamos viendo a un humano real.

"Algunos trucos para identificar contenido creado con A.I. (siglas de inteligencia artificial en inglés) funcionan ahora. Pero quién sabe si en un par de meses queden obsoletos", indicó a EsPaja.com el director de Cazadores de Fake News, Adrián González. Y agregó:

"En el caso de los videos de House of News Español (uno de los canales con narrativa favorable al oficialismo que se eliminó de YouTube en marzo de 2023), nosotros notamos que los avatares de Synthesia Synthesia (la empresa de contenido digital contratada para crear los videos) eran bastante tiesos, pero el último que se publicó gesticulaba tan bien con las manos, que llegamos a pensar que era un actor real contratado. Es probable que (en tiempo real) ya estén mejorando los videos de Synthesia y otros softwares similares".

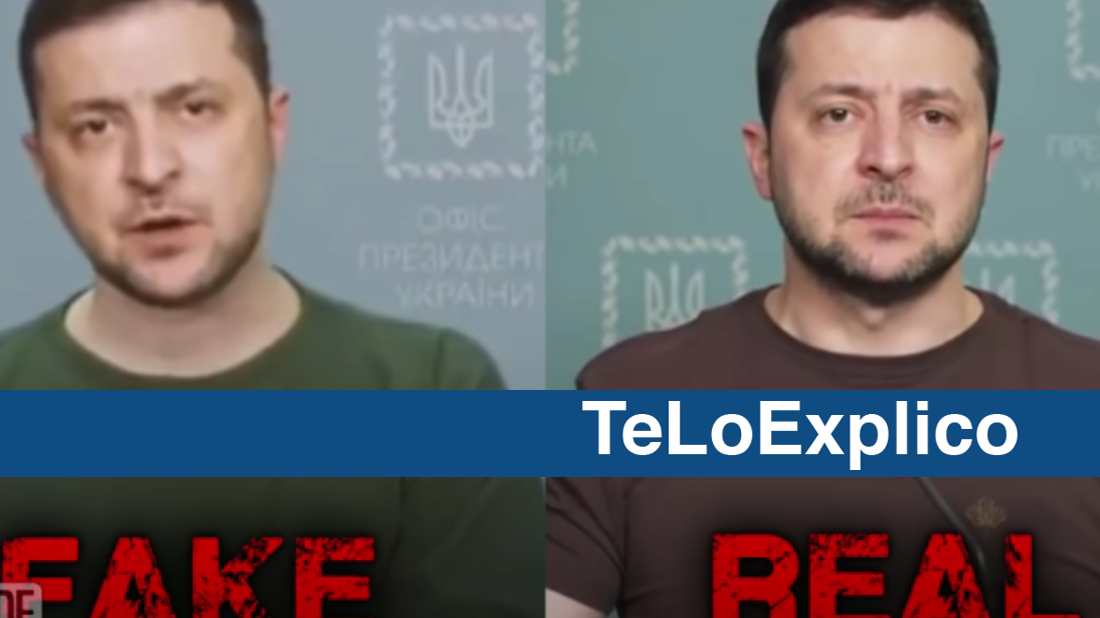

Deepfake como propaganda de guerra: manipulación digital de un personaje real (el presidente de Ucrania) empleada durante la invasión de Rusia en 2023. El Volodymyr Zelensky "chimbo" pedía la rendición a sus propias tropas

No basta una herramienta: hay que emplear una paleta 🎨

En síntesis: para 2023, no basta una sola herramienta para detectar que estamos ante un personaje célebre cuya imagen ha sido manipulada para que haga una acción o emita un discurso falsos. O ante un presunto periodista de una cadena internacional que nos habla en inglés sobre la "recuperación" de la economía de Venezuela. Hay que recurrir a todo un abanico de adiestramientos y recursos.

1. Coordinación imperfecta entre labios y voces. Por su complejidad, el movimiento de labios sigue siendo uno de los talones de Aquiles de la animación digital de humanos, sobre todo cuando careces del presupuesto de una película de Hollywood (en esta área de la tecnología, el dinero sí lo puede hacer casi todo).

Todos sabíamos que era poco probable que una reina británica de 94 años practicara un baile sensual en formato TikTok. Casi seguramente se trataba de una broma digital, eso sí, presentada de manera bastante creíble. Pero si observamos con atención el famoso video de deepfake de Isabel II de Inglaterra en la Navidad de 2020, podemos detectar cierta discoordinación entre la boca y su voz.

El falso mensaje de Navidad de la reina Isabel en 2020 fue elaborado para alertar sobre la manipulación digital de videos, pero de todos modos recibió críticas por su contenido "irrespetuoso"

Detectar avatares se ha vuelto "un tema muy complejo", indicó a EsPaja.com Arnaldo Espinoza, periodista especializado en tecnología. "Pero muchas de estas animaciones 'mueren' generalmente por la boca, como el pez, o por la ausencia de sincronía entre boca y voz. Una de las razones por las que los videos de House of News Español se narraban en inglés era porque, en ese idioma (de pronunciación más fluida), se facilita la coordinación de los labios con los sonidos".

2. Imperfecciones o saltos en las secuencias de imágenes. Se perciben especialmente cuando ponemos los videos en cámara lenta, una función disponible en YouTube. Nuevamente, este tipo de imperfecciones en la continuidad, junto con los movimientos corporales o gestos faciales poco "naturales", son típicos en videos en los que la inversión tecnológica no es extremadamente alta.

Deepfake: ejemplo de un pequeño error de continuidad (detectable con cámara lenta) en la secuencia de movimientos del rostro de Donald Trump. Video completo en el canal de Deutsche Welle

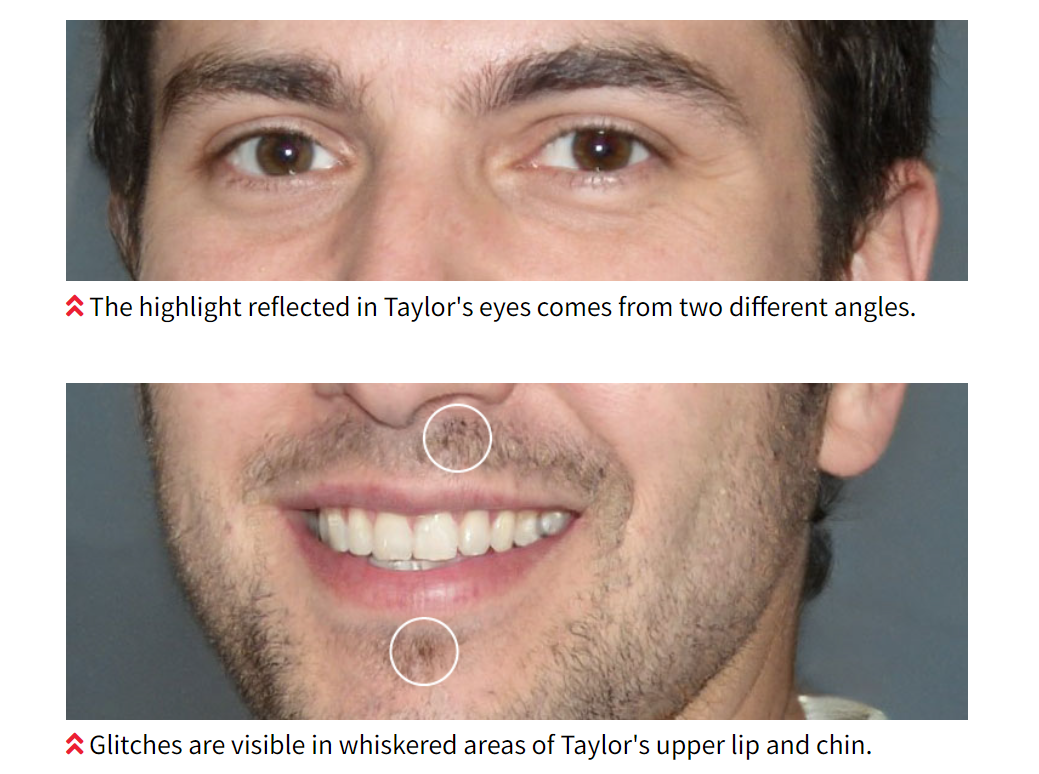

3. Detalles en los ojos, el vello facial, el cabello o la textura de la piel: a pesar del desarrollo de la tecnología de animación, todavía es cuesta arriba recrear de manera realista estas partes del cuerpo humano, que requieren una gran precisión. Cuando hay pequeños descuidos en el acabado de las imágenes manipuladas, en inglés se les suele llamar glitches, que se podría traducir como "malfunciones".

Investigación del medio Reuters en 2020 sobre la imagen de un "escritor" llamado Oliver Taylor que en realidad no existía. Por ejemplo, el reflejo de la luz en ambas pupilas tiene ubicaciones diferentes

Investigación del medio Reuters en 2020 sobre la imagen de un "escritor" llamado Oliver Taylor que en realidad no existía. Por ejemplo, el reflejo de la luz en ambas pupilas tiene ubicaciones diferentes

4. Inconsistencias en el contexto: en un video de deepfake prácticamente nunca vemos "solo" una persona. Suele haber un contexto: accesorios, decorado, iluminación, detalles secundarios, etc. Y las inconsistencias "rarosas" en este contexto también nos puede dar pistas de que estamos ante una manipulación digital. Por ejemplo, un Donald Trump que le da la mano a Nicolás Maduro... con seis dedos.

5. Apoyo de la inteligencia artificial. Ninguna tecnología es "buena" o "mala" por sí misma. Eso depende del uso que le demos. Aunque suene paradójico, se pronostica que la herramienta más util para detectar videos manipulados con inteligencia artificial... será la propia inteligencia artificial.

Y es lógico: un video de alta definición contiene una enorme cantidad de información. Debe recordarse que cualquier creación audiovisual no es más que una sucesión de imágenes fijas que dan la sensación de movimiento.

Una de las aplicaciones de la inteligencia artificial es que nos ayuda a analizar casi instantáneamente gigantescas magnitudes de datos difícilmente procesables por un cerebro humano (o muchos de ellos) durante su período vital. Por ejemplo, hay programas de A.I. que pueden comparar de manera milimétrica las inconsistencias de gestos, movimientos y detalles anatómicos entre una persona real y un "doble" digital.

Algunos de estos programas presumen de contar con 99% de eficacia para detectar deepfake. Pero debe recordarse que se trata de un combate entre gato y ratón: para cada tecnología que detecta engaños, suele aparecer luego otra capaz de vencerla, y viceversa.

6. Análisis de "reputación". Si un presunto "periodista" no se identifica de manera clara, pasa a ser sospechoso. Si se presenta con un nombre y apellido, pero estos no cuentan con una trayectoria previa que les respalde en buscadores de Internet, también suma puntos a su carrito de sospechas.

Si aparece dando "noticias" en un canal de YouTube relativamente nuevo y con un bajo número de suscriptores, pero cuyas visualizaciones han sido artificialmente aumentadas con avisos pagados, esas sospechas se amplifican todavía más.

Si el creador o los patrocinadores de ese presunto "canal noticioso" tampoco están identificados... Bueno, ya estamos elaborando un cóctel bastante completo de suspicacia. Muchos de estos elementos externos a la estricta animación digital permitieron configurar el marco de la desinformación con avatares favorables al oficialismo de Venezuela y destapada en febrero de 2023.

7. Entrenarnos para dudar también de las imágenes. En EsPaja.com tenemos un método que se basa en cuatro premisas: Detente, Duda, Busca y Coopera. Generalmente aplicamos estos principios a mensajes de texto en WhatsApp, contenido sacado de contexto, una manipulación elemental de fotos, etc. La detección de "avatares" que difunden información manipulada a favor de la narrativa oficialista nos alerta de que estamos ante una nueva realidad informativa aún mucho más compleja.

Estamos obligados, también, a detenernos, dudar y buscar información acerca de todo video que, a simple vista, parezca mostrar personas o situaciones reales. Y cooperar para difundir la existencia de campañas cada vez más elaboradas y realistas de desinformación. Que habrá que atacar desde mútiples ángulos.